Bei WestAI unterstützen wir Unternehmen bei der Entwicklung von innovativen Anwendungen mit KI. Eine Kooperation zwischen dem Forschungszentrum Jülich und dem u-form-Verlag zeigt nun, wie eine solche Zusammenarbeit aussehen kann.

Im letzten Jahr haben Künstliche Intelligenzen erfolgreich verschiedene Prüfungen bestanden, darunter das US-Examen für Medizin. Nun sollen sie menschlichen Prüflingen zu mehr Lernerfolg verhelfen. Der u-form Verlag will dazu mit der Hilfe von Experten des Forschungszentrums Jülich einen KI-Prüfer für die Prüfungsvorbereitung entwickeln. Im Rahmen eines gemeinsamen Forschungsprojekts sollen verschiedene Sprachmodelle getestet und in Trainingsprogramme des Verlags integriert werden.

„Ein Teil unserer Zusammenarbeit wird darin bestehen, die Eignung großer kommerzieller Modelle wie GPT-4 und Claude 2 mit Open-Source-Modellen zu vergleichen, deren Einsatz für Unternehmen beispielsweise aus Datenschutzgründen erstrebenswert ist“, erklärt Fritz Niesel, KI-Forscher und Berater bei WestAI am Jülich Supercomputing Centre.

Ein erster Anwendungsfall ist die IHK-Abschlussprüfung für Kaufmannsberufe. Der auf die Prüfungsvorbereitung spezialisierte u-form Verlag bietet entsprechende Trainingsprogramme für Auszubildende an. Mittels KI soll es möglich werden, Freitext-Antworten automatisiert zu bewerten und den Lernenden Fehler aufzuzeigen.

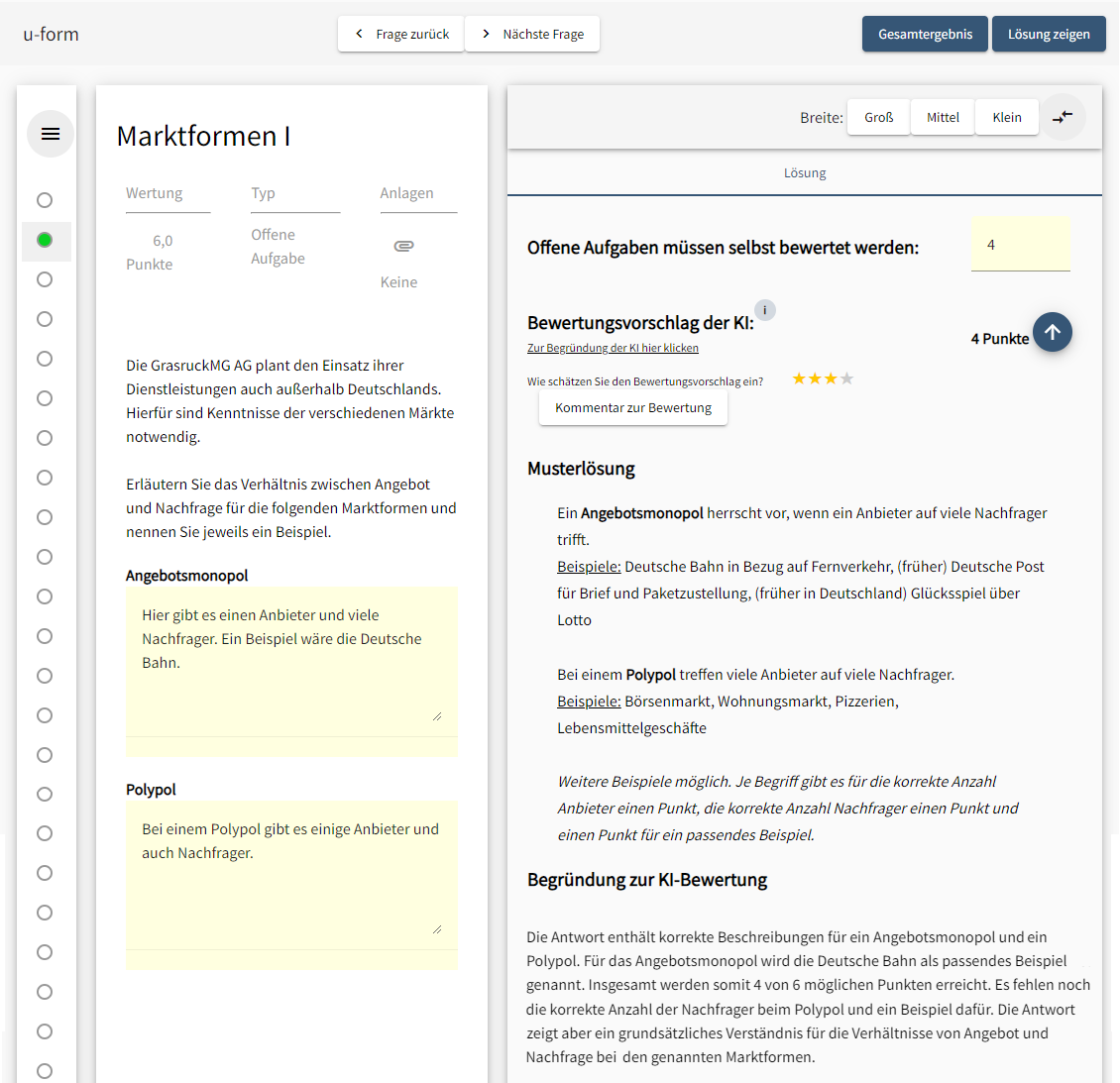

Eine solche Testfrage ist beispielsweise, wie sich ein „Angebotsmonopol“ und „Polypol“ voneinander unterscheiden. Bisher konnten Prüflinge ihre Antworten nur selbstständig mit einer Musterlösung abgleichen. Die KI soll ihnen künftig zusätzlich ein direktes Feedback zur Richtigkeit und Vollständigkeit ihrer Antworten liefern.

„Die Bewertung mit Claude 2 von Anthropic funktioniert im Prinzip schon ganz gut“, erklärt Fritz Niesel. In einige Punkten steht die KI jedoch vor dem gleichen Problem wie ein menschlicher Prüfer: Frei formulierte Antworten sind manchmal mehrdeutig oder ungenau. Nicht immer lassen sie sich klar in ein Bewertungsschema einordnen. So kann etwa „Nachfrager“ in der unteren Beispielantwort sowohl mehrere als auch nur einen einzelnen „Nachfrager“ bedeuten. Die Punktevergabe ist dann ein Stück weit Auslegungssache.

„Viele Open-Source-Modelle sind im Vergleich dazu aktuell noch deutlich schwächer. Speziell im Deutschen haben sie noch starke Defizite, die meisten Modelle wurden primär auf Englisch trainiert“, sagt Fritz Niesel. Für Open Source spreche aber, dass man Anwendungen selbst aufsetzen und auf eigener Hardware betreiben kann. So lasse sich wertvolles Firmenwissen vor ungewollter Verbreitung schützen.

Antwort von Mixtral-8x7B

Die Antwort ist teilweise korrekt, aber nicht ausführlich genug. Für Angebotsmonopol und Polypol wird ein Beispiel genannt, aber die Anzahl der Anbieter und Nachfrager wird nicht klar dargestellt. Für Angebotsmonopol wird jedoch die korrekte Beschreibung und das korrekte Beispiel verwendet, weshalb 2 Punkte vergeben werden. Für Polypol wird zwar eine richtige Beschreibung verwendet, jedoch fehlen ein Beispiel und die Anzahl der Nachfrager, weshalb nur 1 Punkt vergeben wird. Ein weiterer Punkt wird für die richtige Verwendung eines Begriffs vergeben.

Im oben genannten Testfall kommt Mixtral-8x7B zum gleichen Ergebnis wie Claude 2. Das Sprachmodell gilt vielen als derzeit bestes Open-Source-Modell. Doch in seiner Begründung schneidet es schlechter ab. Diese ist teilweise schlicht falsch oder unverständlich. So wurde in der Antwort – anders als in der Begründung angegeben – gar kein Beispiel für ein Polypol genannt. Zudem vergibt Mixtral-8x7B einen Punkt für „für die richtige Verwendung eines Begriffs“. Doch welcher sollte das sein?

„Hier zeigt sich eine typische Schwäche, die beispielsweise mittels Prompt Engineering – also speziell zugeschnittener Eingaben für die KI – und einigem Fine Tuning verbessert werden kann“, schätzt Fritz Niesel. Im Projekt wollen die Partner nun weiter untersuchen, ob sich Open-Source-Modelle ähnlich effektiv wie die leistungsstärkeren kommerziellen KIs als Prüfungshelfer einsetzen lassen.